Когда был принят и как вступает

Регламент Европейского Союза «Об установлении единых правил в области искусственного интеллекта» (Закон об ИИ) вступил в силу 1 августа 2024 г. Однако о нем заговорили только сейчас, поскольку общие положения, запреты и вопросы информационной грамотности в области ИИ начали действовать со 2 февраля 2025 г.

Важность закона

Закон об ИИ является первым в мире актом, который настолько детально регулирует вопросы использования ИИ – 180 статей преамбулы и 112 статей самого закона на 144 листах.

В преамбуле к Закону об ИИ отмечено, что государства поддерживают развитие нейросетей и осознают их важность в прогрессе. Однако Закон об ИИ регулирует, в какие сферы жизни ИИ не должен вмешиваться, какие права человека должны охраняться от новых технологий, каким образом ЕС и государства-члены будут обеспечивать контроль и как это все повлияет на бизнес.

В российском законодательстве пока отсутствуют нормы, сопоставимые с Законом ЕС об искусственном интеллекте, однако прослеживается устойчивая тенденция к их формированию. Европейский опыт может повлиять на развитие соответствующего регулирования в ближайшее время.

На кого распространяется

- Поставщики и их представители – размещают на рынке или вводят в эксплуатацию системы ИИ;

-

Пользователи - физические или юридические лица, использующие систему ИИ под своим руководством для профессиональных нужд;

-

Импортеры и дистрибьютеры систем ИИ;

-

Производители систем ИИ.

Закон об ИИ не применяется к системам ИИ, которые используются для военных и оборонных целей и по вопросам национальной безопасности, а также с целью научных исследований и разработок. Международные организации, использующие системы ИИ с целью международного сотрудничества, также не подпадают под требования, если они обеспечивают адекватные гарантии в отношении прав и свобод человека.

Если физическое лицо использует систему ИИ для собственных нужд, не связанных с профессиональной деятельностью, то требования Закона об ИИ на него не распространяются.

Когда нельзя применять ИИ

К запрещенным практикам использования ИИ относятся оценки и прогнозы поведения людей, который связаны с их биометрическими данными:

- распознавание лиц из Интернета для создания баз данных;

-

анализ эмоций на рабочих местах;

-

классификация людей на основании их расы, религии или сексуальной ориентации;

-

оценка вероятности совершения преступления по личным характеристикам.

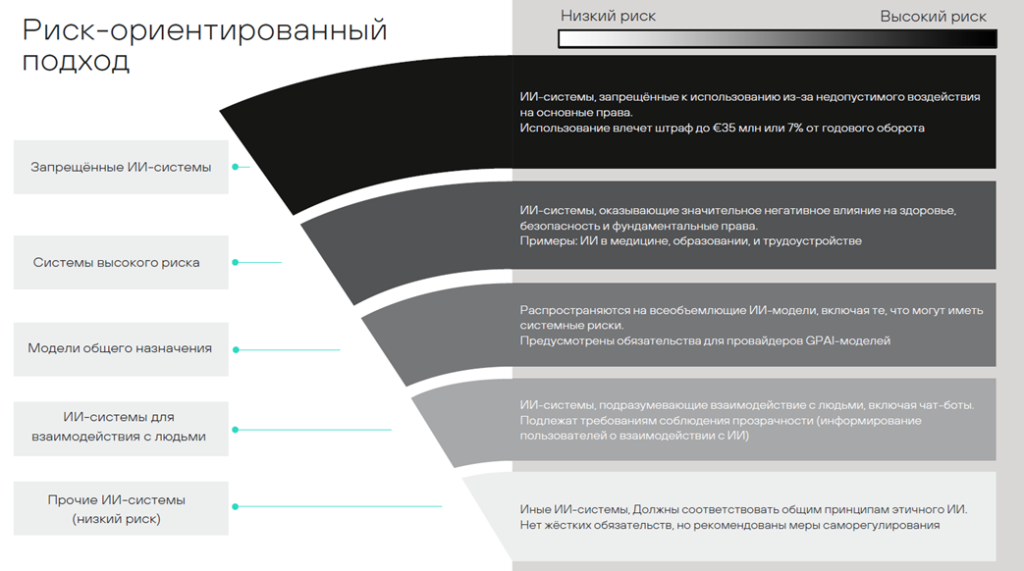

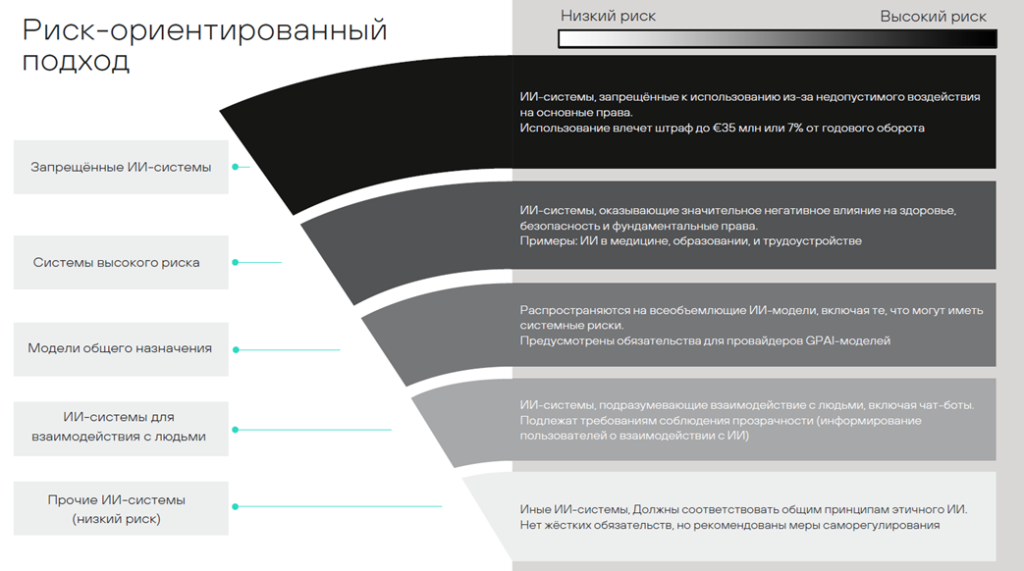

Подход по рискам

Закон об ИИ вводит классификацию рисков по восходящей: чем выше риск, тем больше обязательств и выше штрафы.

Система ИИ относится к высокому риску, если она сопряжена со значительным риском причинения вреда здоровью, безопасности, правам людей или окружающей среде. Если ИИ используется в критической инфраструктуре в качестве компонента безопасности, то она будет относится к высокорискованной системе.

Особое внимание на территории ЕС следует обратить сотрудникам отдела кадров, сотрудникам кадровых агентств и юристам по трудовому праву, потому что использование системы ИИ для отбора соискателей, их оценки, продвижения по карьерной лестнице, расторжения трудовых договоров, распределения функционала и иные вопросы профессиональной компетенции относятся к категории высокого риска.

Работодатели обязаны проинформировать работников и исполнителей об использовании системы ИИ высокого риска в отношении их деятельности, до начала использования системы.

Поставщики систем ИИ с высоким риском должны:

- иметь систему управления рисками;

-

разрабатывать свои системы на основе качественного набора данных;

-

иметь техническую документацию и вести журнал для регистрации событий на протяжении всего жизненного цикла;

-

иметь декларацию соответствия ЕС, маркировку СЕ и зарегистрировать себя и свою систему в базе данных ЕС;

-

сообщать о любых серьезных инцидентах органам по надзору за рынком систем ИИ (по общему правилу – в течение 15 дней, в случае сбоя в критической инфраструктуре – в течение 2 дней, в случае смерти человека – в течение 10 дней).

Закон об ИИ требует от поставщиков обеспечивать хранение данных об идентификации физических лиц, пользующихся системой ИИ. Следовательно, персональные данные и конфиденциальная информация не должны загружаться в систему ИИ, безопасность работы обеспечивается загрузкой обезличенных документов и информации.

Система ИИ высокого риска должна работать таким образом, чтобы человек мог контролировать полученные данные в течение всего периода их использования.

Системы ИИ с повышенным риском должны быть максимально устойчивы к ошибкам, сбоям и иметь возможность резервного копирования.

Импортеры системы ИИ высокого риска обязаны удостовериться, что система ИИ не является фальсификатом, проверить маркировку СЕ и декларацию соответствия ЕС, они также должны хранить документацию на систему ИИ в течение 10 лет после размещения на рынке ЕС.

Если пользователь разместил на системе ИИ высокого риска свое название, товарный знак, внес существенные изменения или изменил ее назначение, то на него распространяются обязанности поставщика системы ИИ.

Какие обязанности есть у пользователя системы ИИ высокого риска:

- использовать в соответствии с инструкцией;

-

разрешить использование только тому человеку, который прошел обучение, имеет необходимые компетенции и может проверять полученные данные;

-

контролировать данные, которые загружаются в систему ИИ – они должны быть релевантными и репрезентативными, а также соответствовать цели запроса;

-

информировать людей, когда они общаются с системой ИИ (чат-боты, виртуальные помощники).

Кодексы поведения

Не являются обязательными для пользователей, но рекомендованы с целью определения правил поведения сотрудников компании для использования систем ИИ. Предполагается, что типовые кодексы будут разрабатываться поставщиками систем ИИ.

Ответственность и штрафы

Если ИИ используется с запрещенной целью, то это влечет за собой штраф в сумме до 35 млн евро или 7% годового мирового оборота (зависит от того, какая сумма больше). Для государственных органов штрафы составят 1,5 млн евро.

За нарушение требований к системе ИИ с высоким риском штраф в сумме 15 млн евро или 3% от годового мирового оборота (зависит от того, какая сумма больше). Для государственных органов штрафы составят 750 000 евро.

Штраф за предоставление недостоверной информации государственным органам составит 7,5 млн евро или 1% годового мирового оборота (зависит от того, какая сумма больше).

Штрафы для средних, малых предприятий и стартапов составят наименьшую из указанных сумм.

Выводы и перспективы

Компании из стран ЕС, вероятно, будут внедрять собственные кодексы этичного использования ИИ, а также предъявлять требования соблюдения положений Закона об ИИ ко всем своим контрагентам, включая тех, кто действует за пределами Евросоюза.

Подход ЕС к регулированию ИИ может стать моделью и для других юрисдикций. В этой связи российским компаниям уже сейчас целесообразно определить внутренние правила работы с ИИ, ориентируясь на международные стандарты.

С учетом особенностей российских законодательных трендов и динамично развивающейся практики применения ИИ, мы рекомендуем обратить внимание на практики закрепления работы с ИИ в отдельных декларациях, определяющих общие концепции использования ИИ в рамках рабочих процессов компании.

Особое внимание стоит уделить использованию ИИ в трудовых отношениях — в соответствии с Законом об ИИ это считается областью высокого риска и влечет дополнительные юридические и организационные обязанности.

Закон об ИИ также возлагает на разработчиков ИИ обязанность по хранению данных и их предоставлению государственным органам ЕС по запросу. В случае использования ИИ-систем европейского происхождения российским компаниям следует внимательно оценивать риски, связанные с передачей конфиденциальной информации, и обеспечивать соблюдение требований по защите данных.